Dossier : Des projets plus ou moins fous

"L'avenir de l'humanité

dépend en grande partie de notre planète et l'avenir de

notre planète

dépend en grande partie de l'humanité."

Sa Sainteté le 14ème Dalaï-lama

1/ Energie : Les potentiels existants

L'eau

pour la production d'énergie : réalité et expérimentations

Ces articles sont issus d'un site de l'île de

la réunion ou se déroulent la plupart des expériences

détaillées ci-dessous

Les origines

L'eau a été la principale source d'énergie utilisée

dans l'industrie pendant 4000 ans.

La première machine pour tirer partie de l'hydraulique a été

la roue à aubes inventée par les égyptiens 2000 ans

avant J-C. Les barrages qui furent d'abord utilisés pour l'irrigation,

ont été développés par le royaume de la Reine

de Saba, l'actuel Yemen, 5 siècles avant notre ère.

Au fil du temps, les technologies ont évolué et les moulins

à eau ont été délaissés au profit de

centrales hydrauliques

Les centrales hydrauliques

Les centrales hydrauliques sont essentiellement destinées à

la production d'électricité.

Le principe est d'exploiter l'énergie potentielle, associée

à une hauteur de chute d'eau, pour en tirer de l'énergie

cinétique qui sera par la suite transformée en électricité

par une turbine et un alternateur. La hauteur d'eau nécessaire

peut être exploitée directement en montagne par une conduite

forcée ou artificiellement créée par un barrage.

La puissance installée en France est de 24.2 GW pour une production

annuelle de 76.5 TWh. Elle représente 12% de l'électricité

produite.

La micro-hydraulique

Cette appelation regroupe tous les systèmes qui exploitent des

ressources hydrauliques de faible intensité.

Elles sont généralement implantées le long des cours

d'eau, sans en entraver l'écoulement. Le débit est contrôlé

au niveau de la prise d'eau. L'eau s'engouffre dans un canal de dérivation

et actionne une turbine avant de rejoindre le lit de la rivière.

Au lieu d'être installée sur un cours d'eau, la micro-hydraulique

peut aussi être utilisée dans les conduites d'adduction d'eau

potable et d'irrigation. Ainsi, chaque réducteur de pression sur

les réseaux d'eau est une source facile de potentiel micro-hydraulique.

L'énergie des courants

1- L'énergie marémotrice

Certains sites présentent des caractéristiques de courants

associés au phénomène de marée exploitable,

à l'aide d'un barrage, pour la production d'électricité.

Les turbines mises en œuvre ont la particularité de fonctionner

dans les deux sens. L'estuaire de Rance en Bretagne (France) est un exemple

réussi d'une usine marémotrice mise en service en 1966.

2- L'énergie des courants marins

L'énergie "hydrolienne" est une filière technologique

en pleine émergence qui utilise les courants sous-marins.

La première installation connectée au réseau en 2003

est opérationnelle au nord de l'Europe.

|

|

L'énergie des vagues

Les vagues, sources d'énergie renouvelable et gratuite, sont créées

par le vent quand il souffle à la surface des océans. Ce

potentiel énergétique est presque infini, il a été

évalué, au niveau mondial, à 2 TW. Le système

OWC (Oscillating Water Column) est basé sur le courant d'air poussé

à travers une turbine grâce à la colonne d'eau oscillante.

C'est un caisson à clapet dans lequel la montée de la vague

joue comme un piston et comprime un volume d'air qui fait tourner un turbogénérateur.

Le "WaveDragon" : Les " ailes " latérales dirigent les vagues vers le centre du système où se trouvent 5 turbines verticales. L'écoulement de l'eau " piégée " dans le bassin de collecte à travers les turbines génère de l'électricité.

Pour en savoir plus sur le Wave Dragon : www.wavedragon.net

Le "Pelamis" : Le système se présente comme un grand serpent articulé (130m de longueur, 3,5m de diamètre et une capacité nominale de 375kW), décomposé en plusieurs segments. Les vagues entraînent des mouvements élastiques au niveau des articulations, reliées à des pistons, qui entraînant eux-mêmes la compression et la décompression d'un fluide contenu dans chaque segment.

Pour en savoir plus sur le Pelamis (site en anglais) : www.oceanpd.com

L'énergie thermique des mers

Son principe consiste à mettre en mouvement un moteur thermique

utilisant la différence de température entre les eaux de

surfaces (22 à 24°C) et les eaux profondes (- 6°C vers

1000 m). Ce procédé n'en est pour l'instant qu'au stade

expérimental.

Sources : http://www.arer.org/

L'usage de la biomasse pour la production d'énergie et comme chimie alternative.

La biomasse est l’ensemble de toutes les matières premières renouvelables d’origine végétale ou animale destinées à des utilisations non alimentaires. Rien qu’en Europe, il existe une centaine d’espèces végétales qui peuvent être utilisées pour la fabrication de produits non alimentaires et pour la création d’énergie. Ces ressources en biomasse sont de trois types:

Les ressources agricoles : Produits des cultures permettant de produire des huiles, des sucres, des fibres et des molécules. (Le Colza, par exemple)

Les ressources forestières : Forêts et co-produits industriels (sciure, copeaux…).

Les déchets : Déchets ménagers et industriels, les parcs à conteneurs, les boues d’épuration permettent de récupérer des gaz de décharge (processus de bio méthanisation).

La biomasse est principalement utilisée sur le plan

industriel dans le cadre de deux activités:

La création d’énergie (ou bioénergie)

: Création de chaleur, d’électricité, production

de combustibles.

La chimie végétale : Polymères bio dégradables

(matériaux composites pour l'industrie), bio lubrifiants (à

base d'huiles végétales), peintures, encres (via les pigments,

les tanins), bio carburants (liquides issus de l’oléo chimie

ou de la distillation de sucres, ester méthylique ou bioéthanol,

sont aussi une base pour la formulation de nombreux composés type

solvants, lubrifiants, détergents, cosmétiques, …)

Le concept de bioénergie est associé à celui des énergies renouvelables. Une énergie est dite renouvelable si le fait d'en consommer ne limite pas son utilisation future. Ces énergies proviennent directement du soleil sous la forme de lumière et de chaleur, ou par le biais des cycles de l'eau, du vent ou de la biomasse. Aujourd'hui, tout indique donc que les énergies renouvelables joueront un rôle grandissant dans notre approvisionnement énergétique.

La biomasse se différencie des autres formes d’énergies renouvelables par deux caractéristiques : Tout d'abord, elle est stockable, et donc susceptible de produire de l'énergie quand on en a besoin. Ensuite elle permet de produire plusieurs formes d'énergies : chaleur, électricité, transport, alors que les autres énergies renouvelables sont mono-produit : PV, éolien, hydro électricité, solaire thermique.

Sur le plan social, la biomasse offre des perspectives en matière d’emploi, fournissant un élément de réponse aux problèmes structurels de surproduction en Europe et un nouveau débouché pour les agriculteurs.

La biomasse permet également de répondre en partie au problème des déchets. En effet, les produits de la biomasse non réutilisables (papiers, cartons) peuvent être recyclés, compostés ou valorisés sous forme d’énergie. Plus de 50% des déchets peuvent ainsi être valorisés. Cette valorisation indispensable à terme au vu de l’augmentation du coût des traitements et de l’interdiction éventuelle, à l’horizon 2010, de la mise en décharge des matières organiques biodégradables.

Sur le plan environnemental, les produits issus de la biomasse présentent des avantages sur leurs équivalents minéraux : biodégradable, neutre par rapport au bilan CO2, non toxique. A noter que cela est vrai si sa gestion s'inscrit dans une logique de développement durable, les effets négatifs de sa valorisation étant de l'ordre de la déforestation et de l’épuisement minéral des sols. Certains écologistes y voient un facteur aggravant du recours à l'agriculture intensive (usage des engrais, des pesticides et des insecticides.) Dans les pays industrialisés, on peut éventuellement parler d'agriculture raisonnée. Mais il est évident que cette maturité environnementale ne s'applique pas aux pays dont la situation économique et sociale ne permet pas encore une intégration réaliste du développement durable.

Enfin, l'utilisation accrue des bioénergies

pourrait partiellement contribuer à réduire le réchauffement

climatique dû aux émissions des gaz à effet de serre,

comme le stipule le Protocole de Kyoto.

Le raisonnement est le suivant : la ressource étant renouvelable,

elle absorbe par la photosynthèse les émissions de CO2 engendrées.

Le CO2 rejeté lors de la combustion est donc compensé, on

dit que le cycle du carbone est fermé. (Par opposition avec les

énergies fossiles qui libèrent en combustion le CO2 qu'elles

contiennent, on dit que le cycle du carbone est ouvert)

Sources : www.valbiom.be et divers

Le regain des centrales solaires dans le monde

Le rêve porté par Themis en 1983 produire de l'électricité en grande quantité grâce aux rayons concentrés du soleil est déjà une réalité. Il existe dans le monde une dizaine de centrales solaires en fonctionnement, d'une puissance totale de 350 mégawatts (MW) moins du tiers d'un réacteur nucléaire français. Toutes ces centrales sont aux Etats-Unis. Mais sous l'impulsion de Kyoto, et face aux incertitudes liées au pétrole, nombre de pays ont lancé des projets de construction : Afrique du Sud, Australie, Inde, Israël, Mexique, Maroc...

En Europe, l'Italie et surtout l'Espagne sont très en pointe, soutenues technologiquement par des industriels allemands. Le nouveau gouvernement de Madrid a inscrit dans son projet énergétique un objectif de 600 MW à l'horizon 2011. «Le prix de rachat de l'énergie solaire par les grandes compagnies d'électricité conditionne le décollage du solaire, explique Manuel Romero-Alvarez, directeur du département énergie renouvelable au Ciemad (centre espagnol de recherche sur l'énergie et l'environnement). En Espagne, il est de 21,6 centimes d'euro, soit trois fois le prix moyen du kilowattheure. C'est très incitatif pour les industriels. En France, avec un tarif à 15 centimes, je comprends que personne ne veuille se lancer.»

Certes, on ne peut pas construire des centrales solaires

où l'ensoleillement est faible. Inversement, les meilleurs emplacements

rassemblés sur les zones tropicales de la planète

n'offrent que peu d'intérêt pour les régions

industrialisées du Nord. «Cependant, rappelle Cédric

Philibert, de l'AIE (Agence internationale de l'énergie), 70 villes

de plus d'un million d'habitants sont situées à moins de

300 km de sites favorables à l'implantation de centrales solaires.»

Actuellement, l'Algérie est en train d'installer deux gros câbles

sous la mer destinés à transporter vers l'Europe méridionale

de l'électricité solaire. Selon un rapport récent

de Greenpeace et de l'Estia (European Solar Thermal Industry Association),

le solaire à concentration pourrait couvrir, d'ici trente ou quarante

ans, jusqu'à 10 % des besoins mondiaux d'énergie.

Sources : Liberation - mardi 26 octobre 2004 - Par

Pierre DAUM

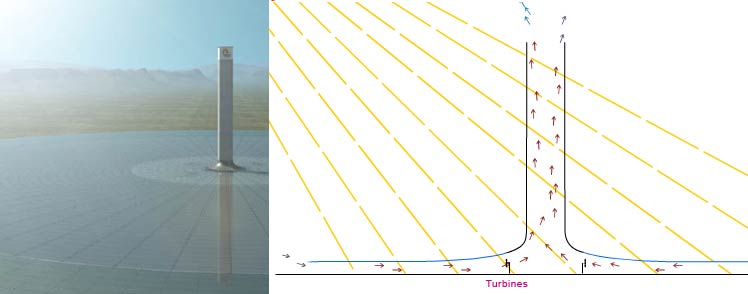

Les solar towers : les tours solaires du désert Australien.

L'entreprise Enviro-Mission développe le plus ambitieux des projets sur le créneau des énergies renouvelables, avec pour objectif à la fois de produire de l'énergie sans consommer de ressources fossiles ni d'émettre de gaz à effet de serre. Leur technologie réside sur le rayonnement solaire via une station thermique de grande envergure qui ambitionne d'approvisionner environ 200 000 foyers "typiques" (capacité : 200 MW.) Par ailleurs, l'installation permettra l’économie de 900 000 de tonnes de rejet de CO2 dans l'atmosphère.

Le projet sera implanté en Australie, avec le soutien du gouvernement australien qui en reconnaît pleinement le potentiel. L'étude de sa faisabilité arrive aujourd'hui à son terme, sa construction devrait démarrer si son financement est aujourd'hui assuré. (Ce qui reste à vérifier en regard des coûts colossaux, plus de 500 000 $)

Le principe du dispositif est le suivant : un collecteur,

c'est à dire un disque translucide de 5 Km de diamètre,

trônant de quelques mètres au dessus du sol, sera destiné

à capter le rayonnement solaire afin de chauffer l'air sous sa

surface, pour créer un courant chaud dirigé vers une cheminée

placée en son centre. La cheminée, haute de 1km sur 150m

de diamètre, permet d'accélérer le flot d'air chaud

grâce au différentiel de température entre son extrémité

haute et sa base. L'air chaud est ainsi propulsé en dehors la cheminée

(Vélocité dans la cheminée : 15m/s).

Les turbines sont disposées à la base de la cheminée,

disposées verticalement à 360° autour de la tour, dans

le flux des courants d'air chauds. Le projet comprend 32 turbines génératrices

d'énergie électrique.

L'installation est conçue pour fonctionner 24h/24 grâce à un réseau de tuyaux dont le matériau absorbe la chaleur le jour pour la diffuser la nuit, permettant de maintenir le courant d'air chaud.

Economiquement parlant, chaque tour solaire est une alternative pertinente aux modes de production énergétique de type charbon ou gaz, avec l'immense avantage de ne produire aucune émission de gaz à effet de serre.

Il est bon de préciser que cette technologie, dédiée aux milieux ensoleillés, ne consomme pas d'eau douce.

Enfin, Cette étude à l'échelle industrielle

est consécutive à un développement expérimental

mené en Espagne dans les années 80, qui a abouti sur un

prototype d'une capacité de production de 50 MW. Cette tour, d'un

diamètre moindre, a tournée pendant 7 ans (15 000 heures).

Le principe de production est donc éprouvé et ne constitue

pas un frein à cet ambitieux projet.

Sources : www.solarmissiontechnologies.com

Energies alternatives? rêvons du potentiel des oceans...

Un peu de science fiction, l’histoire se déroule

sur les océans…

Imaginons que demain, les territoires maritimes dénommés

« eaux internationales » soient exploités au profit

d’un chantier monumental : la réalisation de multiples plateformes

sous marines de production d’énergie électrique. En

substance, un projet de centrales hydro électriques en bordure

des continents. L’objectif serait que la totalité des plateformes

cumulent une capacité énergétique équivalente

à une centaine de nos meilleures centrales nucléaires, cette

énergie serait destinée aux populations vivant non loin

des côtes. Rappelons que la moitié de la population mondiale

occupe une bande côtière large de 200 kilomètres -

soit 1 % seulement de la surface de la terre.

L’idée est la suivante : Chaque dispositif

sous marin est constitué d’une multitude de turbines hydrauliques

de grand diamètre, ou d’hélices sous marines, activées

par la seule puissance des courants océaniques, doté de

super générateurs hébergés sur un réseau

de plateformes de conception analogue aux plateformes pétrolières

conçu pour le forage en haut profonde. En somme, des super centrales

hydro électriques qui redistribueraient l’énergie

produite vers les continents via des pipelines immergés. Leur proximité

côtière permet de limiter la déperdition énergétique

inhérente au transport de l’électricité.

Géographiquement, il conviendrait d’étudier les implantations

possibles en fonction des grands courants marins : équatoriaux

(pacifique ou atlantique nord et sud), au nord de l’océan

indien ou le long des pôles (au nord, à la rencontre du Gulf

stream et de la dérive nord atlantique ou au sud, dans le courant

circumpolaire antarctique, aux abords du tourbillon océanique du

cap Horn).

Les eaux internationales, qui se situent à la limite

des eaux territoriales, c'est-à-dire à une certaine distance

des côtes des pays qui bordent les océans et les pays insulaires,

ne sont actuellement soumises à aucune législation.

Pour autant, des organismes internationaux comme L’ONU sont à

même de faire évoluer le cadre légal existant. Alors,

pourquoi ne pas imaginer que l’ONU se fixe demain une nouvelle mission

: au delà de la création d’un cadre légal,

développer de nouvelles règles de commerce, spécifiques

aux eaux internationales.

On pourrait imaginer les règles suivantes : Les eaux internationales étant la propriété de tous, et non d’un ou de plusieurs pays, il s’agirait de mettre en place un cadre permettant d’y développer une zone d’activité économique sous condition que cette activité soit la propriété de tous, donc financée par tous, et par conséquence dont les bénéfices d’exploitation soient redistribués à tous.

Ce cadre permettrait de lancer un projet tel que celui des supers centrales hydro électriques. Les coûts de mise en œuvre seraient évidements pharaoniques, mais l’idée serait d’obtenir un financement international, c'est-à-dire une cotisation fixée par l’ONU et imposée à l’intégralité des pays industrialisés mais également aux pays en voie de développement. Chaque état serait alors propriétaire d’une côte part du projet, en fonction de sa richesse (donc au prorata de son investissement) Par la suite, la maintenance du parc serait également déléguée à un organisme international.

Et de fait, en terme de redistribution énergétique,

chaque pays produira et touchera son lot d’électricité

en fonction de ses droits, ce qui présente un avantage indéniable

en terme de développement durable (ou plutôt de société

durable) : Les pays en voie de développement deviennent partiellement

autonomes en matière de production énergétique par

conséquence seront moins tributaires des pays riches, et leur production

ne sera plus assujettie uniquement aux ressources naturelles du pays,

ou à l’obligation d’importation…

Cette énergie pourra bien sur être revendu entre pays, et

pourquoi pas sur des règles basées sur le commerce équitable.

Enfin, c’est une façon de caresser le rêve

de fournir l’électricité à tous, et d’imaginer

les conditions de vie que cela pourrait engendrer, autant au niveau sanitaire

qu’alimentaire. Il est bon de rappeler que l’objectif de réduire

d’urgence la pauvreté dans le monde a été gravé

dans le marbre lors du sommet de la terre à Rio en 1992 sous l’égide

des Nations Unis. (ch 3 du rapport de Rio, principes d’actions,

objectifs, activités, moyens d’exécutions)

La volonté de remplir cet objectif est fatalement liée à

une mobilisation internationale autour de projets concrets, et peut être

faut il concevoir les choses avec une certaine démesure quand l’enjeu

est celui de la sauvegarde de la planète ET de l’humanité.

FJ - Tout à redire.

Pour réagir à cet article : écrivez

moi

ITER, l'énergie atomique de demain, surpuissante et peu risquée

Le programme ITER (pour "réacteur thermonucléaire expérimental international", en v.f.) associe pour la première fois les principales nations industrielles dans une recherche jugée décisive pour leur avenir énergétique. Il s'agit de tenter de maîtriser la fusion des atomes, que de nombreux physiciens présentent comme une "panacée énergétique" susceptible de répondre "durablement" aux besoins toujours croissants de la planète en électricité. Début du chantier en 2005. Horizon d'une possible mise en oeuvre industrielle : entre 2020 et 2060.

Iter (le "chemin" en latin) est une démarche commune lancée en 1987 par trois chefs d'Etats : Reagan, Mitterrand et Gorbatchev. La construction du réacteur d'Iter devra démontrer que les techniques de contrôle de la fusion thermonucléaire développées depuis la fin de la seconde guerre mondiale sont mûres pour une exploitation industrielle. Une expérience fondées sur le même phénomène physique que la bombe "H" : la surpuissante énergie dégagée par la fusion de noyaux d'atomes d'hydrogène. Une perspective jugée vraisemblable d'ici 2020 à 2060 par groupes industriels partenaires d'Iter.

Un projet international sans précédent

Placé sous l'égide de l'Agence internationale de l'énergie

atomique (AIEA), Iter réunit l'Union européenne, les Etats-Unis,

la Russie, le Japon, le Canada, l'Inde, la Chine et la Corée parmi

ses membres principaux. Le chantier est prévu pour démarrer

début 2005. Sa construction devrait durer entre huit et dix ans

et son exploitation une vingtaine d'années (ce qui nous mène

en 2035).

La fusion des noyaux d'hydrogène - le plus léger

des atomes - est la principale source énergétique de l'univers,

à l'origine de pratiquement toute la matière qui nous entoure

et nous constitue. La fusion est l'énergie des étoiles.

Dans les régions les plus profondes des astres, la force de gravité

est si grande qu'elle est capable de "compacter" la matière

: les noyaux d'hydrogène fusionnent pour former des noyaux d'hélium,

les noyaux d'hélium donnent des noyaux de carbone, et ainsi de

suite jusqu'aux atomes des métaux les plus lourds. Sur Terre, la

fusion ne peut avoir lieu dans des conditions naturelles, parce que la

force de gravité y est trop faible.

La fusion nucléaire artificielle a d'abord été développée

à des fins militaires. La première bombe "H" (pour

hydrogène) fut testée par les Etats-Unis en novembre 1952

dans le Pacifique. Depuis, des milliers d'ingénieurs atomistes

cherchent à réussir, dans le domaine pacifique de la production

électrique, l'équivalent du passage de la bombe "A"

à fission (celle d'Hiroshima) à la bombe à "H".

Les physiciens considèrent l'énergie de fusion comme potentiellement

plus propre, moins dangereuse et beaucoup plus puissante que la fission

des atomes lourds d'uranium ou de plutonium utilisée par les réacteurs

nucléaires d'aujourd'hui.

Dans une réaction de fusion nucléaire, les noyaux d'hydrogène

qui doivent réagir entre eux portent chacun une charge positive

: ils se repoussent. Cette force de répulsion doit être surmontée

pour que l'énergie de fusion puisse être libérée.

Les militaires y parviennent en utilisant une bombe "A" comme

"détonateur" à l'intérieur de leurs bombes

"H". Impossible de recourir à cette solution à

des fins civiles : la réaction en chaîne de fusion doit alors

être à la fois maîtrisée et confinée.

D'où le demi-siècle de retard pris par les ingénieurs

civils sur les généraux.

La répulsion des noyaux est vaincue lorsque le gaz

d'hydrogène est suffisamment chaud pour former un "plasma"

: un mélange électriquement neutre de noyaux chargés

positivement et d'électrons libres chargés négativement.

Un plasma ayant une température suffisante pour permettre la fusion

(entre 50 et 100 millions de degrés) ne peut être confiné

dans des matériaux classiques, qui seraient immédiatement

détruits par la chaleur.

Pour réussir le confinement, on utilise un champ magnétique.

Le problème central, et non résolu, consiste à chauffer

le plasma et à le confiner dans un champ magnétique approprié

pendant un temps assez long pour permettre la libération de plus

d'énergie qu'il n'en faut pour chauffer et confiner le gaz. Un

seuil critique que le projet Iter est censé permettre d'atteindre.

La technique la plus prometteuse pour parvenir à la maîtrise

du plasma a été inventée au début des années

1960 par le célèbre physicien dissident russe Andrei Sakharov.

La fusion par confinement utilise une chambre circulaire parcourue par

un champ magnétique en forme de "tore", une forme géométrique

qui rappelle à un pneu tordu et un peu froissé.

Depuis les innovations de Sakharov, la fusion civile a fait d'énormes

progrès. Nous connaissons précisément la taille décisive

à partir de laquelle la chambre de confinement permettra de produire

plus d'énergie qu'il ne lui en faut pour fonctionner.

L'installation de fusion expérimentale qui s'approche aujourd'hui

le plus du fameux seuil critique est le Jet (Joint European Torus), en

Grande-Bretagne. Lancé en 1978 par Euratom Jet est parvenu à

plusieurs reprises depuis 1997 à atteindre l'équilibre,

en générant autant d'énergie qu'il n'en absorbe.

Iter sera trop fois plus puissant que le Jet, passant de 5 à 17

millions d'ampères.

Une " panacée " ?

La plupart des spécialistes de l'atome fondent de grands espoirs

dans la fusion nucléaire. L'énergie potentiellement disponible

grâce à la fusion des atomes hydrogènes semble presque

inépuisable. Ceux qui la développent la présentent

comme à la fois moins dangereuse, plus propre et beaucoup plus

puissante que la fission de l'uranium utilisée par les réacteurs

actuels.

La fusion nucléaire n'est pas une énergie renouvelable.

Elle ouvre cependant un horizon de développement bien plus étendu

que les réacteurs à fission. Le "combustible"

de la fusion est le deutérium, un isotope de l'hydrogène

dont la mer offre des quantités pratiquement infinies à

l'échelle des sociétés humaines. Or, d'après

le CEA et Areva, les réserves de minerai d'uranium nécessaires

à la fission pourraient être épuisées d'ici

40 à 100 ans avec les techniques actuelles.

Avec la fusion, le risque de fonte du réacteur (comme

à Tchernobyl) n'existe pas. Si un problème quelconque intervient,

comme une fuite de deutérium, le plasma se refroidit presque instantanément

et la réaction s'arrête d'elle-même.

Une fois utilisé, le combustible de la fusion ne devient pas un

déchet radioactif. Débarrassé du problème

posé par les très dangereux "actinides" (plutonium,

etc.) issus de la fission de l'uranium, l'énergie nucléaire

du futur pourrait s'avérer beaucoup plus "propre" que

celle d'aujourd'hui.

Seuls resteraient radioactives les infrastructures mises en contact plus

ou moins direct avec le plasma de deutérium. Il s'agit d'une radioactivité

qui ne restera problématique que pendant un siècle. Rien

à voir avec les millions d'années de certains des sous-produits

de l'uranium.

Roland Desbordes, président de la Commission de recherche et d'information

indépendante sur la radioactivité (Crii-rad) conteste cette

vision. « Les flux neutroniques autour du tore seront colossaux

(...) Il est encore trop tôt pour affirmer quoi que ce soit concernant

la dangerosité de la fusion. On nous a déjà raconté

n'importe quoi sur les risques supposés mineurs de Phénix

et de Superphénix. Il faut rester prudent."

Toutefois, le président de la Crii-rad reconnaît que "la

fusion peut représenter un avantage énorme par rapport à

la situation actuelle du nucléaire."

Pour échapper à l'épuisement

des hydrocarbures

Parmi les acteurs du programme Iter, nombreux

sont ceux qui voient dans la fusion une porte de sortie probable aux menaces

de pénurie d'hydrocarbures et de réchauffement climatique.

La Chine a beaucoup de charbon, mais peu sinon pas de pétrole.

Pourra-t-elle longtemps assumer une croissance économique galopante,

en étant de plus en plus dépendante des pétroles

russe et arabe, tout en favorisant l'émergence de pollutions encore

plus massives qu'aujourd'hui ? Un fonctionnaire français, qui participe

aux négociations internationales autour d'Iter, commente : "Pékin

ne peut compter que sur un miracle technologique. De plus en plus d'ingénieurs

chinois disent espérer que ce miracle, ce sera la fusion."

Sources : Transfert.net (13-11-2003)

Opinion : Iter, la grande illusion

Bilan énergétique

Pour réaliser la réaction prévue dans Iter, il faut

faire fusionner deux atomes, l'un de deutérium, qu'on trouve en

très petite quantité dans l'eau de mer, l'autre de tritium,

qui n'existe pratiquement pas sur terre. On obtient, par fusion, de l'hélium.

Au-delà des aléas de production de ce tritium, la réaction

vise à générer des neutrons de très grande

énergie. Il faudra ensuite en récupérer l'énergie,

la transformer en chaleur pour produire de la vapeur ou un gaz à

haute température, détendre le tout dans une turbine, pour

enfin produire de l'électricité. A quel coût énergétique

? Quelle quantité d'énergie pour extraire le deutérium

et le tritium, les stocker, les injecter dans le réacteur ? Quelle

consommation d'électricité pour maintenir le plasma confiné

? Quel rendement final pour l'électricité produite par Iter

? Les publications des tenants de ce projet restent curieusement muettes

sur ces questions cruciales.

Environnement

Les promoteurs d'Iter expliquent que la fusion, au contraire de nos réacteurs

actuels (qui utilisent une réaction de fission), ne produit pas

d'actinides mineurs, pas de plutonium, dangereux pour des centaines de

milliers d'années, pas de déchets de très haute activité.

Si les deux premiers arguments sont exacts, le troisième est grossièrement

faux. Il faut, en effet, bien comprendre qu'un tel réacteur est

fait pour produire des neutrons de très grande énergie (dix

fois plus énergétiques que ceux des réacteurs de

fission), qui doivent, pour transmettre leur énergie, traverser

les parois métalliques du réacteur, les fragilisant et les

usant du même coup très rapidement. D'où la nécessité

de remplacer ces parois régulièrement.

Mais ce n'est pas tout, car l'impact de neutrons sur le métal le transforme à son tour en produit radioactif. A chaque opération de remplacement des parois (un cinquième environ tous les ans), c'est une masse de matériaux usés d'une radioactivité comparable à celle d'un coeur de nos centrales actuelles à fission qu'il faudrait décharger. Sans compter la pollution de l'ensemble de l'installation par le tritium qui diffuse très facilement à travers tous les matériaux...

Dans son appel contre l'implantation d'Iter au Japon, Masatoshi Koshiba, prix Nobel de physique 2002, évalue la quantité de déchets cumulée au cours de la vie d'Iter à 40 000 tonnes.

Il paraît donc indispensable, avant d'aller plus loin, de constituer un dossier sérieux - il n'existe pas aujourd'hui ! - sur la nature, la quantité de déchets radioactifs, les risques associés et les solutions envisagées pour s'en prémunir.

Risques d'accident et de prolifération

Là, c'est le tritium qui est en cause : c'est un produit très

volatil et hautement radioactif. On considère que 15 à 20

kg de tritium suffiraient pour faire fonctionner Iter pendant quelques

milliers d'heures par an, ce qui représente une activité

totale de l'ordre de 100 millions de curies. On envisage, dans un avenir

encore lointain, de ne le produire qu'au fur et à mesure des besoins,

à raison de quelques grammes ou quelques dizaines de grammes par

heure, ce qui limite a priori les conséquences de fuites accidentelles

dans la boucle production/extraction/stockage du tritium.

Plus grave... Le tritium n'est pas seulement l'un des composants de la bombe «H» ; c'est aussi, à faible dose, un excellent adjuvant des bombes atomiques «classiques» à uranium enrichi ou à plutonium. C'est ainsi qu'il est employé à raison de quelques grammes par unité pour miniaturiser et rendre beaucoup plus efficaces les bombes «classiques», permettant leur usage dans des missiles à longue portée. Si la technologie de fusion se répand comme le souhaitent ses promoteurs, ce sont des tonnes de tritium qui seront produites annuellement et disséminées dans de très nombreux pays. Il sera alors quasiment impossible de contrôler les flux de tritium avec assez de précision pour éviter le détournement des quelques grammes nécessaires à la fabrication d'une bombe à fission de faible encombrement.

Vendredi 16 avril 2004

Par Benjamin DESSUS et Jacques TESTARD et Dominique VOYNET

Sources publiées sur le forum "rezoweb" (extraits)

Pour en savoir, plus, le site info nucléaire diffuse

plusieurs analyses et communiqués en défaveur du projet

Iter.

Voir le dossier "Le fantasme du réacteur à

fusion nucléaire ITER" : www.dissident-media.org/infonucleaire/iter.html

Recherche : Le CNRS a pour ambition la transmutation des éléments radioactifs

Le CNRS et le Centre d'étude de l'énergie nucléaire belge (SCK•CEN) viennent de signer un contrat dans le cadre d'un projet européen Myrrha de réacteur piloté par un accélérateur. Ce projet vise la réalisation d'un prototype qui permettra notamment d'ouvrir la voie à des études sur la transmutation des déchets hautement radioactifs. Les deux organismes contribuent ainsi à un usage plus sûr et efficace de l'énergie nucléaire et de ses applications.

Myrrha sera la première démonstration mondiale d'une nouvelle catégorie de systèmes nucléaires appelés "Systèmes pilotés par accélérateur" ou SPA (en anglais : Accelerator driven systems ou ADS). Contrairement aux réacteurs classiques, un SPA est une installation sous-critique, c'est à dire une installation qui limite le risque d'emballement lors de la réaction en chaine de fission des noyaux fissibles

Un des avantages de ce système est qu'il permettrait

de transmuter les déchets nucléaires. C'est ce que va tenter

de démontrer le programme de recherche européen grâce

à Myrrha. La transmutation est la transformation d'un isotope en

un autre par une réaction nucléaire induite par des neutrons.

On fait appel à ce type de réaction pour transformer des

isotopes radioactifs à vie longue (millions d'années) en

isotopes radioactifs à vie plus courte ou en isotopes stables (déchets

qui se désactivent à un niveau naturel au bout de trois

à sept cents ans) en vue de réduire l'inventaire radiotoxique

à long terme des déchets radioactifs.

Source : CNRS, le 17/02/2005

3/ Ils ont fait ou ils vont faire...

La plus grande ferme éolienne off shore du monde

Le gouvernement irlandais a approuvé les plans de

la plus grande ferme éolienne off shore du monde. Elle devrait

compter 200 turbines de 80 m de haut qui produiront 10% des besoins en

électricité du pays, ce qui permettra de réduire

de 13 millions de tonnes les émissions de CO2 et de contribuer

à réaliser les objectifs du protocole de Kyoto.

La construction sera gigantesque, elle s'étalera sur 27 km, au

minimum à 7 km du rivage. La compagnie Eirtricity qui réalise

et gére le projet utilisera un banc de sable non visible - il est

entre 5 et 25 métres sous l'eau -, le Arklow, qui longe le rivage

dans le sud de l'Irlande.

Monsieur Fahley, le ministre de la mer, à évidemment reconnu

que les turbines seraient visibles de la terre par temps clair mais ne

devraient pas détériorées le paysage. Il a souligné

l'importance de passer "dans une nouvelle époque" pour

l'énergie et qu'il était temps d'utiliser les deux énergies

renouvelables, le vent et la mer, qui sont abondantes en Irlande.

Eirtricity souhaite commencer les travaux au printemps et commencer à

fournir de l'électricité dès l'automne.

Dans un premier temps, ce sera 60 mégawatts pour atteintre 520

mégawatts au final. L'énergie éolienne est actuellement

en plein boom. En 2001, la production irlandaise a augmenté de

31% ce qui en fait la croissance la plus rapide de l'industrie énergétique.

L'Europe vient de mettre à jour ses prévisions

de production pour 2010 passant de 40000 MW à 60000 MW.

Rappelons que l'Allemagne produit déjà 8000 MW et est le

1er producteur mondial , les USA suivent loin derrière avec 4150

MW puis l'Espagne, 3300 MW et le Danemark, 2500 MW.

Innovation : une nouvelle génération d'éolienne sans nuisances

L'eolienne est l'incarnation de l'énergie propre, mais elle présentait jusqu'ici des défauts dûs à leur taille, facteur de dégradation des paysages. elle produit de plus des nuisances sonores et son efficacité est limité à la bonne dsiposition des vents.

L'entreprise Gual-industrie propose un concept d'éolienne avec un axe vertical, et non plus horizontal. L'architecture repose sur un stator (partie statique) qui enrobe le rotor (partie en rotation) vertical. Les profils aérodynamiques des ailettes du stator et des aubes du rotor ont été déterminées pour favoriser tantôt l'écoulement de l'air vers le centre du dispositif, tantôt le renvoyer vers l'extérieur lorsqu'il se présente selon la mauvaise direction. C'est en effet ce flux d'air - issu de vents multidirectionnels - qui en temps normal ralentit une éolienne, en s'opposant au sens de rotation du rotor. Dans le cas du système StatoEolien, le vent multidirectionnel ne perturbe pas sa rotation, il resiste de plus à des vents très forts (220km/h), les vibrations disparaissent par le maintien du rotor, donc le niveau sonore est quazi nul. La vitesse en bout de pales des éoliennes à hélices peut facilement atteindre 400 km/h, les aubes du ''StatoEolien'' ne dépassent pas 85 km/h, ce qui élimine les vibrations et réduit considérablement les efforts centrifuges. Par ailleurs, de faibles vitesses de rotation offrent un niveau de sécurité amélioré.

Un premier modèle de 3m de diamètre produisant

8.000 kWh/an a ététesté sur le toit d'une villa bioclimatique

témoin. Il existe d'autres modèles de diamètre plus

important et donc plus puissant. Le ''StatoEolien'' a été

conçu principalement pour une implantation en ville où il

s'intégrerait facilement dans le paysage urbain, mais également

en mer (production off-shore) comme sa structure lui permet de résister

aux vents les plus violents.

Site du construcuteur avoir, (le schéma du

fonctionnement) : www.gual-industrie.com

Sources : www.actu-environnement.com - 10/04

Innovation pour la réduction des émissions polluantes des moteurs diesels

Une nouvelle technologie environnementale suisse, développée

par l’umtec en partenariat avec l’industrie et avec le soutien

de l’OFEFP, permettrait de réduire ''radicalement'' les émissions

d’oxydes d’azote des moteurs diesel. Il s’agit d’un

système de dénitrification à installer sur les véhicules

lourds, qui diminue de plus de 90 % le rejet de ces polluants précurseurs

d’ozone. Ce système fonctionne indépendamment du moteur,

ce qui permet de le monter sur tous les véhicules diesel, même

les anciens modèles, qui progressent ainsi directement de la norme

Euro 1 à la norme Euro 5 (applicable en 2009).

Les valeurs limites d’émission des moteurs diesel ont été

progressivement abaissées depuis le début des années

90 pour réduire la pollution atmosphérique, en particulier

celle due aux oxydes d’azote. Après la norme Euro 1 en 1993,

c’est aujourd’hui la norme Euro 3 qui est en vigueur.

Cette nouvelle technique environnementale a déjà fait ses

preuves dans la pratique : un bus Volvo de 1993 conforme à la norme

Euro 5 circule depuis 18 mois en Suisse.

La nouvelle technique de dénitrification des véhicules diesel

comprend trois éléments : Un filtre à particules

agréé VERT pour retenir les suies, un catalyseur SCR (Selective

Catalytic Reaction) pour réduire les oxydes d'azote, un catalyseur

d’oxydation du Monoxyde de carbone (CO) et des hydrocarbures.

L’OFEFP a commencé à promouvoir ces

technologies en 1997. Il finance ainsi des installations pilotes pour

accéler le processus d'expérimentation menant à la

commercialisation.

Sources Actu environnement 05/04/2004